1.11最小二乘法应用实例

最小二乘法(又称为为最小平方法,二乘就是平方的含义),是用来衡量两个模型(样本模型与实际模型)之间距离(准确来说是欧氏距离)的一种方法,其背后的原理求凸函数的最小值。其应用很广泛,在线性回归算法中起到核心作用。两个模型之间的距离可表示为:

最小二乘法有不少优势,如简单明了、易解释。但也存在很多不足,对模型要比较简单,稍微复杂一点(如模型中参数多几个)或条件宽泛一点,可能就无法处理。当然,对于这些问题,我们可以采用梯度下降法解决。梯度下降法将在后续章节介绍。

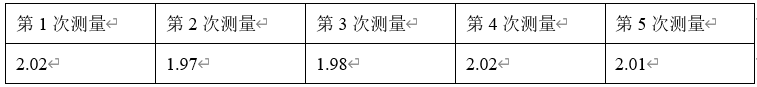

这里我们先看一个简单实例,假设一个裁缝师傅有一块长2米的布,他共量了5次,但每次都不一样,具体数据如下,根据这些样本数据,如何确定其最终的结果呢?这个问题我们可以利用最小二乘法来解决。

单位是米

问题1:这个问题的目标是什么?

问题2:求平均值是一种直观方法,但这种方法好像不足让人信服,有人说,是否可以用出现次数多的那个为准?

问题3:如何用用最小二乘法确定最终结果,如何设定这个实际模型?

问题4:这个问题很简单,还可以做哪些延伸?如果由一维变为多维该如何处理?

问题5:如是否可以把这个问题转换为一个概率模型?然后,把用欧氏方法来衡量两个模型之间的相似度,转变为利用交叉熵方法来衡量两个分布之间近似程度?

问题1:主要目的就是通过这些演变数据获取背后的真实数据

问题2: 最小二乘法的本质是用欧氏视角去衡量两个模型之间的近似度,通过优化方法使它们之间的相似度最大化(距离最小化)。为更好理解,把这些点用坐标表示出来。

这是样本数据,我们假设样本数据背后反应的实际数据为y=y ̂这样一条直线,把这条直线视为实际模型,然后利用最小二乘法求出y ̂的值。

这个计算过程,实际就是求各点到直线y=y ̂的距离(或样本与实际值的误差)最小化,计算过程如下图所示:

显然函数 是一元二次函数,是凸函数,故其驻点就是最小值点。

是一元二次函数,是凸函数,故其驻点就是最小值点。

对 求导,并令其为0得:

求导,并令其为0得:

解之得:

这个结果就是求各个样本点的平均值,即 这个模型与样本模型最接近。

这个模型与样本模型最接近。

问题4:加下来我们介绍梯度时,将介绍如何多维数据的情况。

问题5:这个问题如果用概率统计的思想来处理,该如何处理呢?

概率统计中需要有一个随机变量,随机变量的分布,衡量不同分布之间的相似度等。

实际值与样本的误差可作为一个随机变量:

假设这个随机变量的概率为 ,该误差是一个随机及独立的变量,正常情况下,这个概率应该满足正态分布(因正态分布的熵最大),不妨假设满足标准正态分布

,该误差是一个随机及独立的变量,正常情况下,这个概率应该满足正态分布(因正态分布的熵最大),不妨假设满足标准正态分布 。

。

这里y作为一个普通变量(非随机变量),故可以使用最大似然估计也可求出y的值,也是

真可谓异曲同工!

大家不妨试一下。